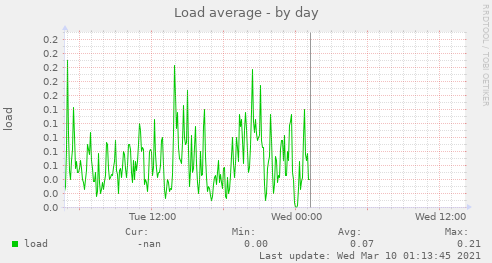

Lágrimas de sysadmins al ver esta imagen.

OVH es el proveedor de hosting más grande de Europa y un top ten en el mundo y uno de sus datacenter ha quedado totalmente destruido por un incendio.

Actualmente nos enfrentamos a un importante incidente en nuestro DataCenter de Estrasburgo con un incendio declarado en el edificio SBG2. Los bomberos llegaron inmediatamente al lugar, pero no pudieron controlar el incendio en SBG2. Todo el sitio ha sido aislado, lo que afecta a todos nuestros servicios en SBG1, SBG2, SBG3 y SBG4. Si tu producción está en Estrasburgo, le recomendamos activar tu Plan de Recuperación ante Desastres. Todos nuestros equipos están totalmente movilizados junto con los bomberos. Te mantendremos actualizado a medida que haya más información disponible

Hace cuatro años 2017 la misma compañía sufrió una caída en sus servidores debido a un problema de suministro eléctrico, aunque se recuperó varias horas después. Sin embargo, este incendio definitivamente fue más desastroso porque si los clientes alojados ahí no hicieron respaldos probablemente perdieron todo.

Actualización: 464 mil dominios offline por el incendio

Muy Europa/OCDE/Primer Mundo serás, pero el incendio no pudo ser controlado por los bomberos y se llevó puesto no solo equipamiento (que es reemplazable) sino que los datos y la información que ahí se contenían, además de muchos servicios interrumpidos. ¿Alguien lloró cuando se les rompió el notebook y perdieron la tésis y las fotos porque no respaldaron? Imagínense un datacenter completo.

Cuando los hombres vemos que a otro hombre le pegan una patada en las canicas nos retorcemos igual como empatía genital, así que de igual manera no pude evitar estremecerme cuando leí la noticia con mi corazón de sysadmin así que creí necesario escribir algo al respecto.

Los ricos también lloran

OCDE, Primer Mundo, Europa, museo de louvre, gente en bicicleta pedaleando al trabajo. Muy moderno todo pero si a ellos se les quema un datacenter completo que queda para esta larga, angosta y tercer mundista franja de tierra.

Puede que implementar un sofisticado sistema de respaldo, una solución de contingencia o migrar a la nube parezca costoso, pero ese costo tienes que equipararlo a lo que le cuesta a tu institución el no brindar servicios por un largo tiempo o la pérdida de datos. Imagínense que se quedan sin correo laboral por cuatro horas, ¿cuánto dinero perdería tu institución, tu empresa? Sistema de facturación, negocios, la base de datos, etc, etc.

La importancia de los respaldos, los planes de contingencia y hacer las preguntas correctas.

Hay cursos completos de esto así que no esperen algo académico, simplemente para sensibilizar a los no expertos vamos a hacer dos preguntas.

Primera pregunta

Imagínate que haces respaldo una vez a la semana a tu servicio de correo y a tu sistema de facturación. Justo, 10 minutos antes de que se inicie el respaldo semanal SE ROMPE TODO. Ya sea porque alguien metió las patas, te hackearon, virus, lo que sea. Perderías una semana de la historia de correos y de facturación de toda tu institución.

¿Puedes tolerar perder todo eso? No, es mucho. ¿Entonces cuánto tiempo de información y datos podrías tolerar perder? ¿Dos días, un día, una hora, 15 minutos?

Hay sistemas de respaldo para cada necesidad pero tienes que considerar que un sistema que te garantice una pérdida mínima es más costoso.

Segunda pregunta.

Brindas servicio a clientes y usuarios internos por internet, ya sea sistema de correo, de facturación, un sistema propietario, lo que sea. Hay un corte de energía en tu datacenter, los sistemas de alimentación de contingencia aguantan un rato pero se terminan apagando. Nada se ha destruido y seguramente cuando vuelva la energía todos tus datos e información van a estar ahí (cero pérdida), pero dejas sin sistemas a todos tus clientes y a todo el personal de tu institución. Llamas a los técnicos y hay caos porque nadie sabe bien que pasó, así que comienzan un análisis punto por punto. Pasan los minutos, las horas y no se arregla nadie sabe por qué.

¿Cuánto tiempo podrías tolerar estár sin servicio? ¿15 minutos? ¿Una hora? ¿Un día? ¿Una semana?

Hay métodos en que automáticamente vas llevando los datos y sistemas a otro datacenter o a la misma nube, de tal manera que si falla tu datacenter principal puedes activar todo desde otro lado y seguir con los sistemas arriba. También tiene un costo pero tú debes determinar si lo vale o no.

La nube al rescate

Ahora muchos servicios y sistemas pueden llevarse a la nube con lo que te ahorras problemas domésticos como el consumo energía, mantención de servidores, espacio físico, cumplir protocolos, etc, etc, aunque antes de que corrar a contratarlo recuerda que detrás del velo de misterio la nube sigue estando alojada en un datacenter. Así es, queridos lectores, debajo de todo ese maquillaje de glamour y tecnosexualidad la nube sigue siendo un computador alojado en un datacenter de algún lugar del mundo con conexión a internet aunque los mayores proveedores de servicios en la nube tienen sus sistemas distribuidos entre datacenters, así que la destrucción de uno de sus edificios no te dejaría con los pies en la calle. De todas maneras, antes de correr a contratar un servicio en la nube pregunta si está distribuido en dos o más datacenters y la política de respaldos.

Salvo excepciones, deberías tender a llevar tus servicios a la nube.

Arde un edificio de OVH, el mayor servicio de alojamiento de Europa

OVH, el mayor proveedor de servidores de Europa, ha sufrido un incendio que ha calcinado un edificio por completo.

www.adslzone.net

www.adslzone.net

3.6 million websites taken offline after fire at OVH datacenters | Netcraft

3.6 million websites taken offline after massive fire at OVH datacenters

Camaradas sysadmins, si tienen anécdotas o experiencias de caídas de servicio este es el preciso momento de compartirlas.

Última modificación: